Audyt SEO - optymalizacja strony od A do Z. Na czym polega audyt SEO?

Spis treści

- Co to jest audyt SEO?

- Na czym polega audyt SEO?

- Rodzaje audytów SEO

- Co zawiera kompleksowy audyt SEO?

- Jak powinien wyglądać audyt?

- Narzędzia do audytu SEO

- Kiedy wykonać analizę SEO?

- Ile trwa audyt SEO?

- Zlecenie audytu SEO

- Ile kosztuje audyt SEO?

- Darmowy audyt SEO, czy to możliwe?

Co to jest audyt SEO?

Nim zaczniemy analizować jakie korzyści niesie ze sobą audyt strony internetowej, to przede wszystkim zdefiniujmy, czym jest audyt SEO.

Audyt SEO (SEO jest akronimem od Search Engine Optimization) to proces oceny strony internetowej pod kątem potencjalnych ulepszeń dotyczących jej widoczności w wyszukiwarkach. Ocena ta jest zazwyczaj przeprowadzana przez eksperta SEO lub zespół SEO. Audytor używa różnych narzędzi i metryk, aby móc zaproponować usprawnienia bądź znaleźć istniejące błędy na audytowanej stronie internetowej. Zebrane w audycie SEO uwagi wykorzystywane są przez programistów, twórców treści oraz inne osoby odpowiedzialne za stronę do optymalizacji witryny.

Audyt SEO jest narzędziem, które pomaga właścicielom stron internetowych zidentyfikować słabe punkty ich witryn. To pierwszy krok do zrozumienia, jakie aspekty strony wymagają poprawy i jakie działania należy podjąć, aby witryna lepiej odpowiadała na potrzeby użytkowników i wymagania wyszukiwarek, oraz osiągała wysokie pozycje w wynikach wyszukiwania na główne frazy kluczowe związane z prowadzoną działalnością.

Na czym polega audyt SEO?

Audyt strony WWW sam w sobie nie rozwiązuje problemów napotkanych podczas analizy. Jego wynik traktować jako listę zadań do wykonania w celu zwiększenia widoczności w wynikach wyszukiwania, a w konsekwencji — zwiększenia ruchu organicznego.

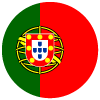

Składowe audytu SEO są podobne dla każdej strony internetowej i obejmują:

- szczegółową analizę kluczowych elementów strony z perspektywy SEO i ocenę ich optymalizacji,

- identyfikację mocnych i słabych stron optymalizacji serwisu,

- wykrycie niezgodności strony z wytycznymi dla webmasterów,

- wskazówki dotyczące optymalizacji poszczególnych elementów.

Zoptymalizowana strona internetowa, przyjazna zarówno użytkownikom, jak i robotom indeksującym, wymaga stałego dostosowywania do najnowszych trendów, wytycznych dla webmasterów oraz algorytmów wyszukiwarek (w przypadku wyszukiwarki Google).

Dzięki audytowi dowiesz się, jak twoja strona prezentuje się w wyszukiwarkach oraz jakie są jej mocne i słabe strony. Kiedy już to zrozumiesz, możesz zacząć wprowadzać odpowiednie zmiany w celu poprawy pozycji twojej witryny wynikach wyszukiwania.

Rodzaje audytów SEO

Audyt SEO polega na kompleksowej ocenie strony pod kątem jej optymalizacji dla wyszukiwarek. Jednak w zależności od specyficznych potrzeb i celów danego serwisu, jego zakres może się różnić. Istnieje kilka kluczowych obszarów witryny internetowej, na których może skupiać się analiza. Na ich postawie możemy wyznaczyć kilka rodzajów audytu SEO ze względu na zakres analizy:

- Audyt on-site - skupia się na analizie strony z wewnątrz, obejmując kwestie techniczne, strukturę, dostępność oraz jakość i optymalizację treści;

- Audyt off-site - polega na badaniu elementów zewnętrznych wpływających na widoczność strony, takich jak autorytet strony, poprzez analizę linków przychodzących i weryfikację obecności marki w mediach społecznościowych;

- Audyt techniczny - obejmuje szczegółowy przegląd aspektów technicznych strony, począwszy od jej budowy, przez indeksowanie i crawlowanie, po szybkość działania.

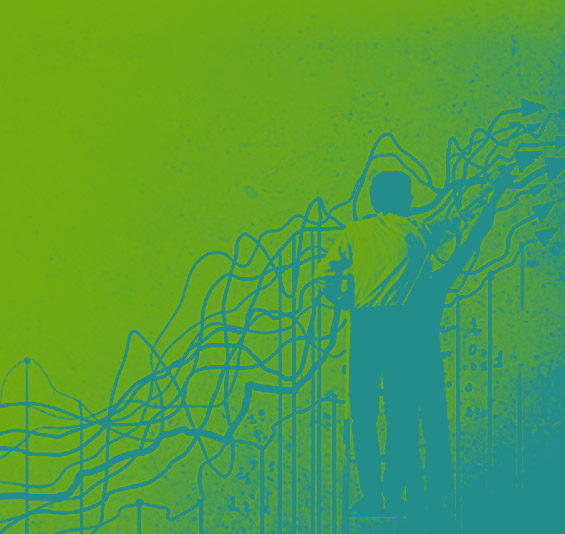

- Audyt podstawowych wskaźników internetowych (Core Web Vitals) - polega na weryfikacji czy strona spełnia wytyczne Google dotyczące podstawowych wskaźników internetowych, kluczowych dla doświadczenia użytkownika;

- Audyt słów kluczowych - to analiza doboru słów kluczowych zarówno w istniejącej treści, jak i pod kątem nowych tematów;

- Audyt konkurencji - polega na porównaniu strony z jej najbliższymi rywalami w wyszukiwarkach, identyfikując różnice i szanse na wyprzedzenie konkurencji w wynikach wyszukiwania;

- Audyt jakości contentu - skupia się na badaniu jakości treści publikowanych na stronie, weryfikując ich strukturę, zawartość i długość, oraz zagęszczenie słów kluczowych, unikalność i inne aspekty.

- Audyt renderowania JavaScript - to ocena, czy dynamiczne elementy strony są poprawnie renderowane i indeksowane przez wyszukiwarki.

Wybór odpowiedniej metody audytu jest ważny dla uzyskania rzetelnej oceny strony internetowej i zidentyfikowania obszarów wymagających optymalizacji. Poniżej przedstawiamy trzy główne rodzaje audytów SEO ze względu na sposób ich wykonania:

- Audyt manualny - wszystkie działania wykonywane są ręcznie, co pozwala na wykrycie problemów, których nie wychwycą narzędzia automatyczne. Jest to najbardziej szczegółowy, czasochłonny i kosztowny sposób przeprowadzania audytu.

- Audyt automatyczny - wykorzystuje narzędzia do automatycznego skanowania strony, sprawdzania parametrów technicznych i wykrywania błędów. Niestety bez czynnika ludzkiego, który sprawdzi i zinterpretuje wyniki, nie będzie on nigdy w pełni wartościowy.

Korzystając z narzędzi typu Ahrefs lub SemRush warto skorzystać z opcji regularnych automatycznych audytów, by na bieżąco być informowanym o ewentualnych błędach na stronie. - Audyt manualno-automatyczny - łączy w sobie zalety obu metod, począwszy od wstępnej automatycznej analizy, po manualną weryfikację wyników. To najlepsza metoda, która pozwala na rzetelny audyt strony.

Co zawiera kompleksowy audyt SEO?

Dokładny audyt SEO wymaga szczegółowej analizy wielu różnych elementów strony i jej widoczności w Internecie. Wykorzystanie odpowiednich narzędzi i metodyczne podejście do każdego z obszarów pozwala na skuteczną optymalizację i poprawę widoczności strony w wynikach wyszukiwania. Poniżej przyjrzymy się kilku obszarom witryny, które należy przeanalizować w ramach audytu, a także omówimy, których narzędzi SEO warto użyć na poszczególnych etapach.

Analiza widoczności

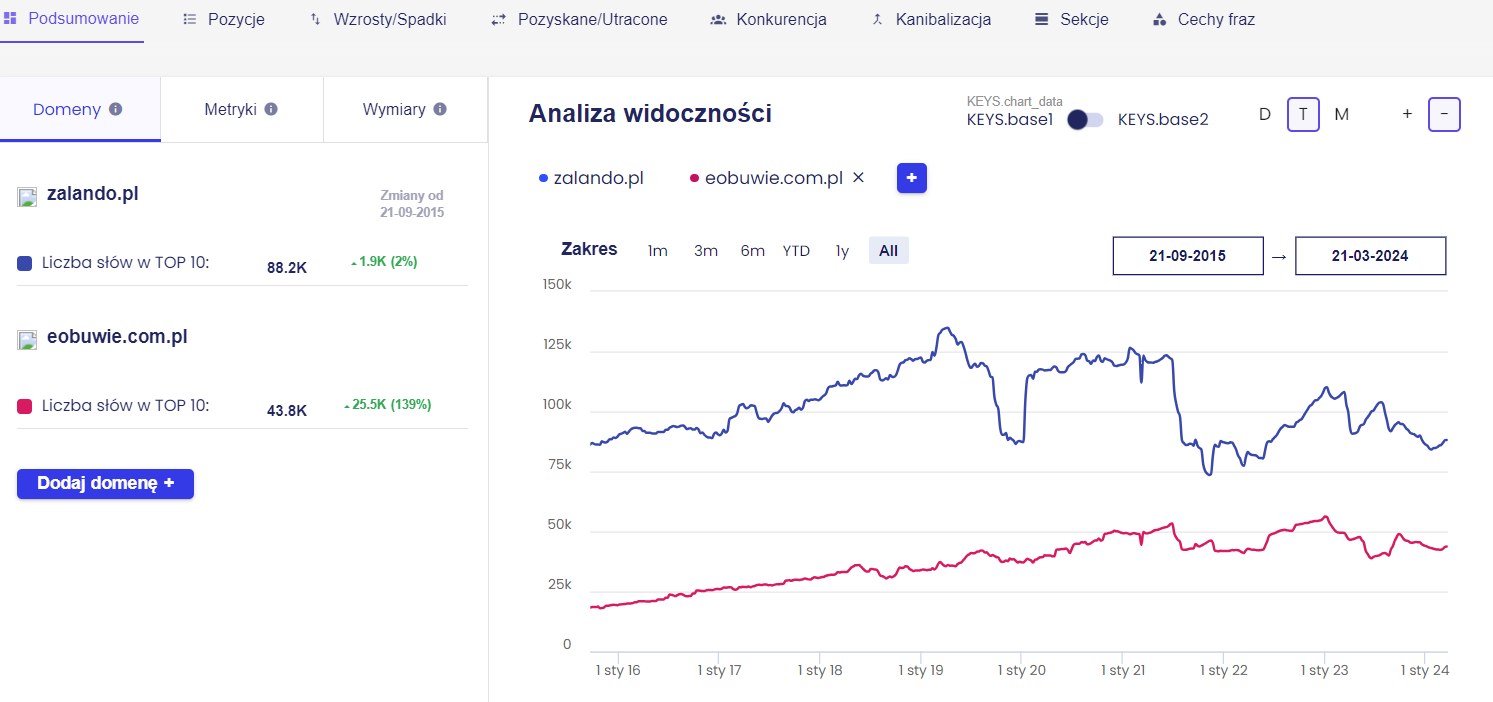

Analiza, na jakie frazy kluczowe strona jest widoczna w wynikach wyszukiwania, pozwala zrozumieć, jak użytkownicy obecnie znajdują witrynę. Narzędzia takie jak Senuto pomagają w identyfikacji słów kluczowych, na które strona już rankuje, oraz tych, które mogą stanowić potencjał do rozwoju.

Analiza widoczności strony w wynikach wyszukiwania pomaga w odpowiedzi na następujące pytania:

- Jaka jest aktualna widoczność strony internetowej?

- Na jakie frazy strona jest widoczna w wynikach wyszukiwania?

- Jakie pozycje strona zajmuje dla istotnych słów kluczowych?

- Ile ruchu organicznego generują strony?

Pozycje słów kluczowych: Zrozumienie, jakie pozycje strona zajmuje na istotne słowa kluczowe, ma ogromne znaczenie dla oceny skuteczności strategii optymalizacji stron. Korzystając z narzędzi dedykowanych do monitorowania pozycji, możesz na bieżąco reagować na zmiany w rankingach na kluczowe dla Ciebie frazy i weryfikować wpływ aktualizacji algorytmów wyszukiwarek na widoczność strony.

Ruch organiczny: Analiza ruchu organicznego generowanego pozwala na ocenę tego, jak efektywnie strona przyciąga użytkowników z wyszukiwarek. Google Search Console jest tutaj nieocenionym źródłem informacji, oferującym wgląd w skuteczność poszczególnych słów kluczowych w generowaniu ruchu.

Optymalizacja on-page

Analiza słów kluczowych: dzięki narzędziom takie jak Google Search Console, Ahrefs i Senuto sprawdzisz:

- czy strony są zoptymalizowane pod kątem odpowiednich słów kluczowych (zweryfikuj, na jakie frazy widoczna jest strona);

- Czy domena nie ma problemu z kanibalizacją treści (to sytuacja kiedy kilka stron jest zoptymalizowanych pod to samo słowo kluczowe);

- czy publikowane treści pozycjonują się na frazy pomocnicze.

Analiza treści: Unikalność treści jest kluczowa dla uniknięcia problemów z indeksacją i rankowaniem stron. Regularne sprawdzanie treści pod kątem plagiatu zapewnia, że wszystkie materiały na stronie są oryginalne, co jest ważne dla utrzymania zaufania i wiarygodności witryny (skorzystaj z narzędzi takich jak: Copyscape lub Originality.ai). Weryfikacja treści jest nierozłącznie związana z analizą słów kluczowych - zweryfikuj intencję fraz i sprawdź, czy teksty odpowiadają na potrzeby użytkowników.

Analiza meta znaczników: Title tagi są uważane za jeden z czynników rankingowych Google. Zwróć więc uwagę, czy każdy z nich zawiera główną frazę kluczową i jest odpowiedniej długości. Z kolei elementy meta description mogą mieć wpływ na współczynnik klikalności z wyników wyszukiwania. Skorzystaj z narzędzia Screaming Frog by zweryfikować czy znaczniki są unikalne, odpowiedniej długości i zawierają podstawowe słowa kluczowe.

Analiza nagłówków H1-H6: Hierarchia nagłówków na stronie ułatwia użytkownikom i robotom wyszukiwarek zrozumienie struktury treści. Do dobrych praktyk tworzenia nagłówków należą: wykorzystanie tylko jednego elementu H1 w obrębie strony, wykorzystanie w nim głównej frazy kluczowej, tworzenie krótkich i zwięzłych nagłówków H2-H6, które jednak opisują zawartość ich treści. Tu także Screaming Frog może pomóc w identyfikacji problemów z duplikacją nagłówków lub ich nieprawidłową hierarchizacją.

Analiza adresów URL: Logiczna struktura adresów ułatwia zrozumienie zawartości witryny użytkownikom i wyszukiwarkom. Screaming Frog umożliwia sprawdzenie, czy adresy URL są optymalnie skonstruowane, zawierają odpowiednie frazy kluczowe, oraz czy nie wskazują na problemy związane z duplikacją treści.

Analiza linkowania wewnętrznego: Efektywne linkowanie wewnętrzne wspiera SEO, dystrybuując wartość strony i ułatwiając nawigację. Ważne jest, aby linki były logicznie rozmieszczone, zawierały odpowiednie anchor teksty oraz aby w strukturze strony nie występowały osierocone strony (orphan pages), do których nie prowadzą żadne linki wewnętrzne. Strukturę takiego linkowania pomogą przeanalizować narzędzia Ahrefs lub Screaming Frog. Dzięki nim zweryfikujesz orphan pages oraz broken linki lub niechciane łańcuchy przekierowań.

Analiza grafik: Duże pliki graficzne mogą wydłużać czas ładowania strony, negatywnie wpływając na doświadczenie użytkownika i pozycjonowanie. Optymalizacja treści wizualnych, w tym kompresja rozmiaru bez utraty jakości, jest niezbędna dla szybkiego ładowania i dostępności strony. Dobrą praktyką w optymalizacji grafik jest również dodawanie alt tekstów, opisujących zawartość obrazu. W Screaming Frog możesz sprawdzić, czy obrazy mają ustawione atrybuty alt i są odpowiednio osadzone na stronie. Aby sprawdzić jak grafiki wpływają na szybkość ładowania witryny, skorzystaj z darmowego Google PageSpeed Insights.

Optymalizacja techniczna

Instrukcje dla robotów: Aby ocenić dostepność strony dla robotów indeksujących, sprawdź, czy na stronie znajduje się plik robots.txt i mapa witryny. Podczas wykonywania audytu upewnij się, że strona jest dostępna dla robotów i nie zawiera niepotrzebnych blokad, a strony przesłane w sitemapie zwracają kod 200.

Szybkość ładowania strony: Wskaźniki (Core Web Vitals) od Google są kluczowe dla oceny szybkości ładowania strony i ogólnego doświadczenia użytkownika. Narzędzia takie jak Google PageSpeed Insights czy Google Search Console (Podstawowe wskaźniki internetowe) pomagają w identyfikacji elementów, które mogą spowalniać stronę. Wyniki poszczególnych metryk sprawdzisz dla urządzeń mobilnych i komputerów.

Responsywność strony: Google skanując strony korzysta z systemu mobile-first indexing, oznacza to, że wersja mobilna strony jest domyślną wykorzystywaną przez Google do indeksowania i rankingu stron w wynikach wyszukiwania. Dodatkowo popularność korzystania z urządzeń mobilnych, sprawia, że dostosowanie do wyświetlania na różnych typach urządzeń jest kluczowe. Narzędzia takie jak Google Search Console oraz PageSpeed Insights mogą pomóc w ocenie, czy strona jest odpowiednio zoptymalizowana pod kątem różnych urządzeń.

Certyfikat SSL (HTTPS): Certyfikat SSL zapewnia szyfrowaną, bezpieczną komunikację między przeglądarką użytkownika a serwerem. Strony zabezpieczone protokołem HTTPS są oznaczane jako bezpieczne przez przeglądarki internetowe, co zwiększa zaufanie użytkowników i jest preferowane przez wyszukiwarki. Można to sprawdzić, weryfikując, czy adres URL strony zaczyna się od „https://”.

Audyt off-page SEO

Podstawowym elementem audytu off-site SEO strony jest analiza jej linków zewnętrznych. Jakość i ilość linków zwrotnych mają znaczący wpływ na pozycjonowanie strony. Narzędzia takie jak Ahrefs czy Semrush oferują szczegółową analizę backlinków, pomagając zidentyfikować wartościowe linki i potencjalne zagrożenia. Analizując profil linków, warto zwrócić uwagę na następujące elementy:

- liczba linków zwrotnych - zarówno dla całej domeny, jak i głównych podstron, które pozycjonujemy;

- różnorodność i unikalność domen linkujących;

- autorytet domeny/strony linkującej;

- naturalność przyrostu linków;

- różnorodność anchor tekstów.

Skorzystaj z naszej checklisty SEO, aby zidentyfikować kluczowe obszary i działania, niezbędne do osiągnięcia lepszych pozycji w wynikach wyszukiwania!

Jak powinien wyglądać audyt?

Nie ma jednego szablonu dla audytu SEO. Wygenerowany raport to mieszanka wiedzy, doświadczenia i preferencji specjalisty SEO. Najczęściej jednak wynikiem audytu strony WWW jest dokument tekstowy opisujący stan poszczególnych elementów strony oraz rekomendacje ich usprawnienia.

Raport z audytu obejmuje zazwyczaj dwie kategorie: on-site i off-site.

- Raport z zakresu on-site zawiera informacje odnośnie audytowanej strony pod względem jej działania i prezencji w sieci. Informacje dotyczą wyłącznie strony, której dotyczy audyt (a zwłaszcza jej zawartości i struktury);

- Raport z zakresu off-site zawiera wszelkie informacje, które wpływają na optymalizację strony, ale nie są od niej zależne (lub są zależne tylko częściowo). Mowa tutaj głównie o weryfikacji działań link buildingu, których celem jest budowanie autorytetu strony w oczach algorytmów wyszukiwarek.

Zwykle specjaliści SEO wykonujący audyt na końcu podsumowują i priorytetyzują zadania, które należy wykonać, aby zoptymalizować stronę.

Efekty po wdrożeniu zaleceń z audytu SEO

Ostatecznym celem audytu SEO jest pomoc firmie w poprawieniu widoczności jej witryny w sieci, a co za tym idzie polepszenie pozycji w wyszukiwarkach. Wyniki audytu SEO zależą od metody, która została użyta do analizy. Jeśli korzystasz z opcji automatycznego audytu udostępnianego przez narzędzia, zweryfikuj jego wyniki ze specjalistą SEO, który pomoże Ci spriorytetyzować działania.

Analiza poprawności wdrożenia po przeprowadzonym audycie SEO

Audyt nie rozwiązuje problemów, ale tworzy listę zadań, które trzeba wykonać, aby zwiększyć potencjał swojej strony w wynikach wyszukiwania. Trzeba pamiętać, że SEO nie jest czynnością jednorazową ani wykonywaną z dnia na dzień. Poprawa pozycji w wyszukiwarkach wymaga czasu i wysiłku. Wdrożenie optymalizacji wynikających z audytu SEO może (i powinno) finalnie doprowadzić do zwiększenia ruchu organicznego, a w efekcie sprzedaży. Jednakże nie jest to proces natychmiastowy i mogą minąć miesiące, zanim pojawią się oczekiwane rezultaty.

Nawet jeśli nie nastąpią natychmiastowe zmiany w widoczności witryny, odpowiednie wdrożenie wytycznych audytu powinno z czasem przynieść pozytywne rezultaty. Audyt bowiem pomaga nie tylko w rozwiązaniu bieżących problemów, ale daje również informacje o kwestiach, które mogą stanowić barierę dla przyszłych wzrostów. Dlatego niezbędne jest sprawdzenie, czy wszystkie wynikające z audytu wnioski zostały przekute na odpowiednie zadania, a następnie wdrożone na stronie internetowej.

Sytuacja jest inna dla każdej strony internetowej. Warto pamiętać, że największe korzyści z audytu strony internetowej pojawiają się zwykle w ciągu kilku miesięcy od wdrożenia.

Przykładowe efekty po przeprowadzonym i wdrożonym audycie:

- Zmniejszenie liczby błędów na stronie internetowej. Jest to jedna z pierwszych i najważniejszych korzyści, którą czasami trudno od razu zauważyć;

- Wzrost satysfakcji użytkownika, ponieważ użytkownicy są w stanie wykonać swoje zadania łatwiej i szybciej. Ponownie - będzie to cenne w perspektywie średnioterminowej, może też prowadzić do większej ilości pozytywnych recenzji o serwisie;

- Poprawa pozycji strony w rankingach, co prowadzi do zwiększenia ruchu organicznego. Może to potrwać nieco dłużej, zanim stanie się zauważalne;

Zwiększona liczba leadów sprzedażowych, które powinny zwiększyć sprzedaż w perspektywie średnioterminowej; - Bardziej wydajne procesy wewnętrzne, ponieważ w pełni możesz wykorzystać zawartość swojej strony internetowej i zwiększyć sprzedaż offline (lub sprzedaż online poprzez inne kanały). Ten efekt jest trudniejszy do zmierzenia, ale powinien mieć natychmiastowy wpływ na wydajność.

Narzędzia do audytu SEO

Poniżej przedstawiamy listę najlepszych darmowych i płatnych narzędzi przydatnych do przeprowadzenia audytu SEO.

- Microsoft Excel / Arkusze Google – pozwalają przetwarzać wartości z różnych źródeł, sortować je i filtrować, a co za tym idzie - analizować różne pozyskane dane o stronie;

- Google Search Console – to bezpłatna usługa, która pozwala monitorować pozycję strony internetowej w wynikach wyszukiwania Google oraz identyfikować i rozwiązywać problemy związane z indeksacją strony w wyszukiwarce;

- PageSpeed Insight – to kolejne darmowe narzędzie od Google, które służy głównie do pomiaru i wyodrębnienia informacji na temat prędkości ładowania witryny oraz jej wydajności;

- Screaming Frog – to rozbudowany crawler stron internetowych, pozwalający na przeprowadzenie analizy czynników on-site SEO. Dostępna jest darmowa wersja z ograniczoną ilością funkcji oraz wersja płatna, która nie posiada limitów i sprzedawana jest w subskrypcji rocznej;

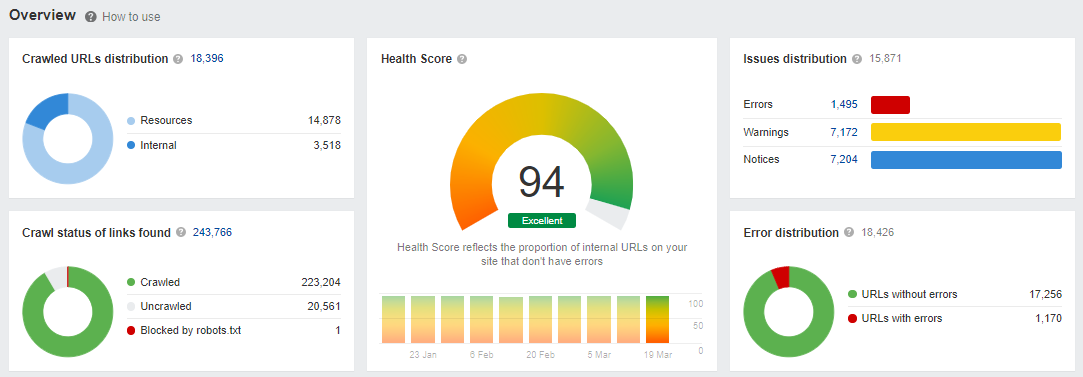

- Ahrefs – jest jednym z kluczowych narzędzi do analizy SEO. Może służyć do analizy linków, wyszukiwania słów kluczowych, estymacji ruchu na stronie internetowej, badania stron internetowych, wyszukiwania treści, a także do audytowania strony oraz śledzenia pozycji stron internetowych konkurencji. Wśród jego funkcji znajdziesz Site Audit, który skanuje wszystkie podstrony witryny, a następnie określa tzw. Health score witryny. W audycie narzędzia znajdziemy wyszczególnione problemy występujące na stronie, ostrzeżenia i uwagi, które warto wziąć pod uwagę optymalizując stronę.

- Cena narzędzia zależy od liczby funkcji oraz liczby osób korzystających z konta. Jednak po zweryfikowaniu własności witryny z użyciem konta Google Search Console, można bezpłatnie skorzystać z Ahrefsa do analizy swojej strony;

- Senuto – to narzędzie służące do sprawdzenia i analizy widoczności stron internetowych w wynikach wyszukiwania Google. Widoczność jest określana poprzez liczbę fraz kluczowych, na które strona rankuje w TOP 3, TOP 10 i TOP 50. Senuto pomaga również zidentyfikować problem kanibalizacji treści, oraz przeprowadzić analizę konkurencji;

- Semstorm – to bardzo ważne narzędzie pozwalające sprawdzić i poprawić widoczność strony internetowej w wyszukiwarkach. Służy między innymi do monitorowania pozycji słów kluczowych oraz ich analizy pod kątem ilości wyszukiwań w przeglądarkach w skali miesiąca. Umożliwia też porównanie z konkurencją;

- Sitebulb – to narzędzie konkurencyjne dla Screaming Frog. Jest to crawler stron internetowych służący do analizy stron internetowych i raportowania wyników optymalizacji;

- Sitechecker – narzędzie oferuje kompleksową analizę strony internetowej, w tym audyt SEO, monitorowanie pozycji słów kluczowych, analizę backlinków oraz sprawdzanie prędkości ładowania strony;

- Clusteric Search Auditor – narzędzie służące do analizy linków wewnętrznych i zewnętrznych weryfikowanej strony. Dodatkowo może posłużyć do sprawdzenia jakości wygasłych domen. Jest to płatne narzędzie, którego zaletą jest dożywotnia licencja;

- YSlow – to darmowe narzędzie bardzo podobne do PageSpeed Insight, jego autorem jest Yahoo!, a wyniki, jakie pokazuje są zbieżne z wynikami narzędzia Google. W wypadku analiz SEO warto jednak wykonać test przy użyciu obu tych narzędzi.

Kiedy wykonać analizę SEO?

Nie ma jednoznacznej odpowiedzi na to pytanie. Jednak zalecamy wykonywanie audytu przynajmniej raz w roku. Jeśli masz możliwość i środki, warto także rozważyć wykonywanie cyklicznych audytów SEO co kilka miesięcy przez różne zespoły. Regularne prace nad SEO i monitorowanie efektów są kluczowe, jeśli zależy nam na efektywnej optymalizacji strony.

Oto lista kluczowych momentów, kiedy najczęściej wykonujemy audyty:

- W procesie tworzenia strony internetowej - aby zbadać rynek i określić, jakie są nasze potrzeby i korzyści z SEO. Warto przeprowadzić audyt wersji testowej strony, by od samego początku była jak najlepiej zoptymalizowana od strony technicznej.

- Po wprowadzeniu dużych/ważnych zmian na stronie, np. migracja strony, zmiana struktury adresów URL.

- Przed rozpoczęciem redesignu strony lub rebrandingu, aby zidentyfikować problemy, które mogą zostać niepotrzebnie przeniesione na nową witrynę.

- Przed i po zmianie strategii dotyczącej wykorzystania słów kluczowych.

- Po aktualizacjach Google, aby zrozumieć, jak zmiany w algorytmach wpłynęły stronę.

- Po każdym zauważalnym spadku ruchu organicznego.

- Zawsze kiedy widzimy ryzyko kar lub innych zagrożeń dla strony.

Na początku współpracy z klientem. Zwykle przejmując klienta po innej agencji lub specjaliście SEO, przeprowadzenie standardowego audytu pozwala określić, na jakim etapie optymalizacji jest dana witryna.

Audyt SEO w procesie tworzenia nowej strony

Audyt strony www można przeprowadzić jeszcze na etapie projektowania, co pozwoli na wdrożenie rozwiązań zgodnych z zasadami SEO. W sytuacji, gdy planujemy stworzyć nową stronę internetową, dobrze jest przedstawić grafikę lub makietę specjaliście SEO. Pozwoli to wzbogacić dokumentację strony o dodatkowe uwagi dla programistów i deweloperów. Dzięki temu już na etapie pisania strony można wystrzec się wielu błędów, a także wykorzystać możliwe szanse.

Taki audyt jest bardzo specyficzny, ponieważ często bazuje na materiałach, które nie są możliwe do sprawdzenia przez dostępne narzędzia. Wiele elementów należy zweryfikować samodzielnie. Audyt SEO makiety to niejako sprawdzian umiejętności SEOwca.

Nie ma praktycznie szans, aby wykonać dla makiety strony darmowy audyt SEO. Nie istnieje żadne narzędzie, które analizowałoby makietę strony i na jej podstawie określało szanse i zagrożenia. Dlaczego też taki audyt musimy zlecić lub wykonać samodzielnie. Wykonanie audytu SEO i stworzenie wytycznych dla powstającej strony może ustrzec ją przed najróżniejszymi problemami, które w późniejszym czasie mogą okazać się trudne do poprawy.

Audyt SEO nowo utworzonej strony

Audyt takiej świeżo utworzonej strony najczęściej skupia się głównie na aspektach technicznych, które mogą zostać wykorzystane przez właściciela w danym momencie lub w przyszłości, po przeprowadzeniu pierwszych czynności promujących stronę w Internecie.

Wykonywanie audytu SEO w tym momencie może być w przypadku niechętnego na zmiany właściciela strony bardzo problematyczne czy wręcz bezsensowne. Jeżeli jednak mamy świadomość, że audyt SEO może wciąż wpłynąć pozytywnie na planowaną promocję strony w sieci – warto wykonać taki audyt.

Można także spróbować wykonać audyt samodzielnie, wykorzystując do tego pomoc zawartą w tym artykule lub korzystając z jednego z wielu narzędzi do audytowania stron.

Audyt SEO po wprowadzaniu kluczowych zmian

Najczęściej właściciele stron decydują się na taki audyt w momencie zmiany wyglądu lub funkcjonalności strony. Nierzadko zmieniana jest struktura strony na inną, bardziej kompleksową i odpowiednią do zmieniającej się oferty firmy. Zdarzają się także sytuacje, gdy właściciel strony zmienia domenę lub łączy kilka serwisów w jeden. Możliwych scenariuszy jest wiele.

Audyt SEO w takich sytuacjach zazwyczaj polega na znalezieniu szans, zagrożeń oraz na analizie słów kluczowych, które warto wykorzystać, by nową lub zmienioną treścią „zaatakować” w wynikach wyszukiwania. Audyt SEO w takim przypadku raczej nie będzie kompleksową oceną całej witryny, a jedynie analizą konkretnego fragmentu strony.

Audyt SEO w eliminacji zagrożeń bądź kar

Różnie toczy się życie witryny. Czasem kilka nie do końca przemyślanych decyzji może sprawić, że strona zostanie ukarana przez algorytm wyszukiwarki. Może być to kara za treści, linki przychodzące lub chociażby zgłoszenie problemu włamania na stronę.

Audyt SEO zostanie tu zamieniony na analizę oraz przygotowanie zestawu działań mających na celu usunięcie problemu. Może to być przygotowanie – po ówczesnej analizie – pliku do narzędzia do zrzekania się linków (z ang. disavow tool), analiza treści na stronie i sporządzenie zaleceń ich poprawy albo diagnostyka strony oraz usunięcie źródła i efektów włamania.

Audyt SEO po przejęciu klienta po innej agencji / specjaliście SEO

Najczęściej zmiana firmy/osoby odpowiedzialnej za pozycjonowanie czy też po prostu promocję w sieci wymaga zweryfikowania wcześniejszych strategii optymalizacji. Nie chodzi jednak o weryfikację raportowanych działań (chociaż jest to istotne), lecz o całościowe spojrzenie czy prowadzona do tej pory strategia SEO była dobra i planowana na dłuższy czas.

Rozpoczęcie przygody z promowaniem strony w Internecie powinno być oparte o dobrze przemyślaną strategię poprzedzoną audytem SEO witryny, konkurencji i wszystkiego, co może się przydać podczas dalszych działań. Audyt SEO w tym wypadku to głównie analiza konkurencji, analiza widoczności strony w wynikach wyszukiwania i w zależności od strony być może także audyt techniczny samej strony.

Ile trwa audyt SEO?

Czas trwania audytu zależy od wielkości i złożoności audytowanej strony internetowej. Średnio dla małej bądź średniej firmy lub startupu — wykonanie prawidłowego audytu SEO zajmuje od kilku dni do kilku tygodni. Większa firma z rozbudowanym serwisem i dużą ilością treści, może wymagać miesiąca lub nawet kilku na analizę.

Zlecenie audytu SEO

Jeśli zdecydujesz się zlecić audyt firmie zewnętrznej, zadanie właściwych pytań audytorowi pomoże ci uzyskać informacje na temat używanych metod, sposobu pracy oraz oczekiwanych efektów. Oto kilka pytań wraz z krótkim wyjaśnieniem, które możesz zadać przed zamówieniem audytu SEO:

Jak działa proces audytu?

Proces audytu składa się ze wstępnej konsultacji w celu określenia twoich potrzeb i celów, a następnie kompleksowego przeglądu technicznego audytowanej strony internetowej w celu zidentyfikowania wszelkich problemów, potencjalnych ulepszeń i zaleceń dotyczących dalszego postępowania.

Co otrzymam po audycie?

Po zakończeniu audytu otrzymasz szczegółowy raport dotyczący wszystkich zidentyfikowanych problemów (zazwyczaj on-page i off-page) na stronie, wraz z rekomendacjami dotyczącymi ich rozwiązania oraz sugestiami dotyczącymi poprawy ogólnej widoczności witryny.

Co zrobić po zakończeniu audytu SEO?

Po zakończeniu audytu strony warto przetworzyć wnioski na zadania i zaplanować wdrożenie sugerowanych poprawek. Należy również przeanalizować dane, które umożliwią zmierzenie obecnego ruchu na stronie i efektywną weryfikację efektów wdrożenia wniosków z audytu w przyszłości.

Jakie dostępy warto nadać audytorom?

Każde przekazanie dostępów administracyjnych do strony powinno być poprzedzone podpisaniem stosownej umowy, która zagwarantuje poufność danych. Im więcej dostępów do danych otrzyma firma audytująca, tym większe będzie miała możliwości analizy strony.

Podstawowe dostępy to panel administracyjny strony (CMS), Google Search Console oraz Google Analytics. W przypadku audytów o bardziej technicznym charakterze warto także dać dostęp do kodów źródłowych strony, co pozwoli audytorowi sugerować potencjalne zmiany usprawniające działanie strony.

Ile kosztuje audyt SEO?

Audyty SEO są wyceniane indywidualnie i zależą od różnych czynników. Koszt audytu SEO może wynosić od kilku do kilkunastu tysięcy złotych. Najczęściej cena zależy od wielkości strony, określanej na podstawie liczby podstron i widoków (strona główna, produkty, kategorie itp.), zakresu analizy oraz branży, w której działa firma.

Darmowy audyt SEO, czy to możliwe?

Czy istnieje możliwość uzyskania darmowego audytu SEO? Niektóre agencje oferują darmowe audyty, które polegają na przeprowadzeniu prostych analiz i podaniu ogólnej oceny strony jeszcze przed rozpoczęciem współpracy. Możemy natknąć się na specjalistów SEO, którzy budują swoje portfolio, lub agencje, które prowadzą promocyjne akcje. Niemniej jednak takie sytuacje nie są częste.

Warto zauważyć, że darmowy audyt, przygotowany przez początkującego specjalistę SEO, może zawierać błędy w postaci złych zaleceń, wniosków lub błędnych założeń. W konsekwencji wdrożenie takiego audytu może przynieść więcej szkody niż pożytku.

Jeśli z różnych powodów nie chcesz wydawać pieniędzy na audyt SEO lub po prostu chcesz nauczyć się, jak przeprowadzać audyty, możesz skorzystać z pomocy zautomatyzowanych narzędzi. Dokładniejszą analizę możesz przeprowadzić, oceniając stronę internetową samodzielnie, korzystając ze wskazówek z niniejszego poradnika oraz bazy wiedzy WhitePress®.

Artykuł oryginalnie opublikowany przez Dominika Fajferka, zaktualizowany przez Paulinę Bajorowicz.